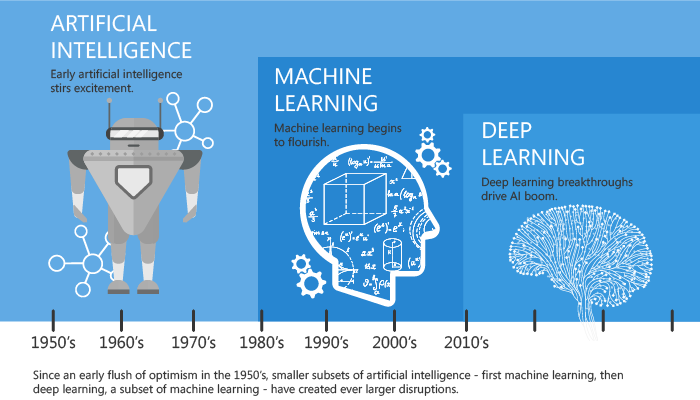

Gartner每年都会发布未来一年的十大科技趋势预测,近两年的十大科技趋势中对人工智能特别是机器学习的发展,在惜字如金的演讲中不惜篇幅,可见未来若干年人工智能将为产业界和我们的生活带来多大的冲击。

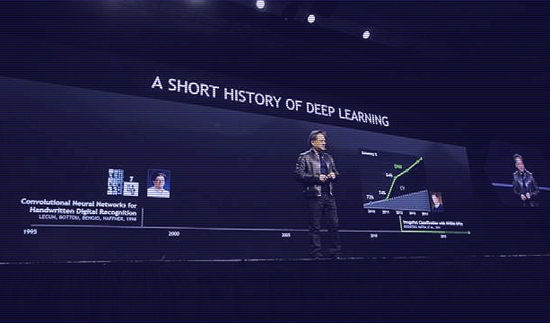

假如我们从此时此刻回首人工智能过去几十年的发展历程,完全符合辩证法螺旋式上升的理论。而这一次深度学习的复兴更是卷积神经网络CNN(Convolutional Neural Network)的复兴。其实卷积神经网络的发展也是经历了一个曲折的过程的。

对于CNN最早可以追溯到1986年BP算法的提出,1989年LeCun将其用到多层神经网络中,1998年LeCun提出LeNet-5模型,神经网络的雏形完成。在接下来近十年的时间里,卷积神经网络的相关研究停滞不前,主要原因:一是多层神经网络在进行BP训练时的计算量极大,硬件计算能力不可能实现;二是SVM等浅层机器学习算法暂露头脚。

2006年,Hinton在《科学》上发表文章,CNN再度觉醒,并取得长足发展。2012年,CNN在ImageNet大赛上夺冠。2014年,谷歌研发出20层的VGG模型。同年,DeepFace、DeepID模型横空出世,将LFW数据库上的人脸识别、人脸认证的正确率刷到99.75%,几乎超越人类。

2015年深度学习领域的三巨头LeCun、Bengio 、Hinton联手在Nature上发表综述对DeepLearning进行科普。2016年3月阿尔法狗打败李世石。2017年10月,AlphaGo Zero 100:0击败Alpha Go!(补充)

1986年~1998年 CNN雏形阶段

这段时间里是CNN的雏形阶段,主要包括BP算法的提出、BP算法在多层神经网络模型中的应用、LeNet-5模型的正式定型。

BP算法的提出

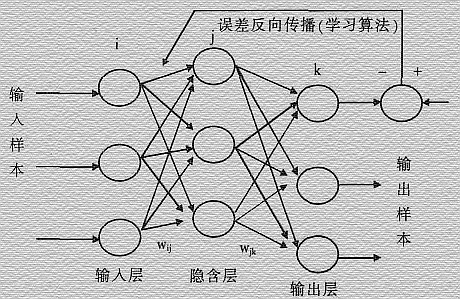

BP算法是在1986年由Rumelhart在《Learning Internal Representations by Error Propagation》一文中提出,BP神经网络的计算过程由正向计算过程和反向计算过程组成。

正向传播过程,输入模式从输入层经隐单元层逐层处理,并转向输出层,每层神经元的状态只影响下一层神经元的状态。

如果在输出层不能得到期望的输出,则转入反向传播,将误差信号沿原来的连接通路返回,通过修改各神经元的权值,使得误差信号最小。

基于BP算法的CNN雏形

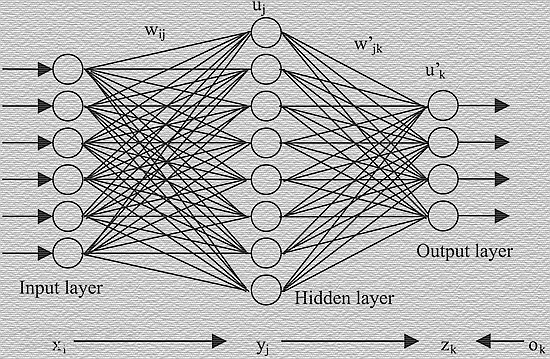

在BP算法提出3年之后,嗅觉敏锐的LeCun选择将BP算法用于训练多层卷积神经网络来识别手写数字,这可以说是CNN的雏形。

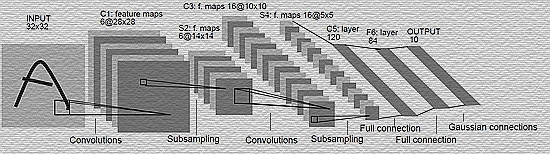

LeNet-5模型的最终定型

LeNet-5模型的提出标志着CNN的正式成型。LenNet-5共有7层(不包括输入层),每层都包含不同数量的训练参数。主要的有卷积层、下抽样层、全连接层3种连接方式。不幸的是接下来这个技术就被打入冷宫,原因如上文所说,它不仅吃设备,而且好的替代品还很多。

2006年 Hinton带领卷积神经网络复兴

这一年可以说是DeepLearning觉醒的一年,标志就是Hinton在Science发文,指出“多隐层神经网络具有更为优异的特征学习能力,并且其在训练上的复杂度可以通过逐层初始化来有效缓解”。这篇惊世骇俗之作名为《Reducing the dimensionality of data with neural networks》。

至此,在GPU加速的硬件条件下,在大数据识别的应用背景下,DeepLearning、CNN再次起飞。

2012年~2014年 重新火热的CNN

这段时间卷积神经网络的相关研究已经进行的如火如荼,学术文献呈井喷式层出不穷,具有代表性的:2012年的ImageNet大赛和2014年的DeepFace、DeepID模型。

ImageNet竞赛上CNN的一鸣惊人

可以说,2012年CNN在ImageNet竞赛中的表现直接奠定了它的重要地位,两个第一,正确率超出第二近10%,确实让人大跌眼镜。

计算机视觉比赛ILSVRC(ImageNet Large Scale Visual RecognitionChallenge)使用的数据都来自ImageNet。ImageNet项目于2007年由斯坦福大学华人教授李飞飞创办,目标是收集大量带有标注信息的图片数据供计算机视觉模型训练。

ImageNet拥有1500万张标注过的高清图片,总共拥有22000类,其中约有100万张标注了图片中主要物体的定位边框。

每年度的ILSVRC比赛数据集中大概拥有120万张图片,以及1000类的标注,是ImageNet全部数据的一个子集。比赛一般采用top-5和top-1分类错误率作为模型性能的评测指标。

AlexNet获得了比赛分类项目的2012年冠军(AlexNet, top-5错误率16.4%,使用额外数据可达到15.3%,8层神经网络)、上图所示为AlexNet识别ILSVRC数据集中图片的情况,每张图片下面是分类预测得分最高的5个分类及其分值。

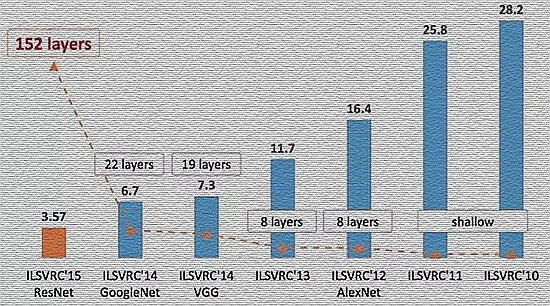

如图所示,ILSVRC的top-5错误率在最近几年取得重大突破,而主要的突破点都是在深度学习和卷积神经网络,成绩的大幅提升几乎都伴随着卷积神经网络的层数加深。

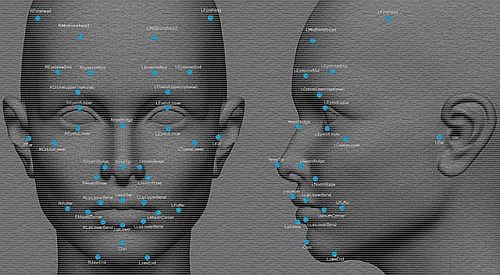

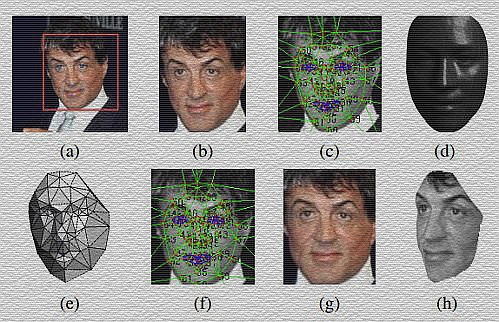

DeepFace、DeepID

在2012年CNN一炮打响之后,其应用领域再也不只局限于手写数字识别以及声音识别了,人脸识别成为其重要的应用领域之一。在这期间DeepFace和DeepID作为两个相对成功的高性能人脸识别与认证模型,成为CNN在人脸识别领域中的标志性研究成果。

至于DeepID,这是由香港中文大学汤晓鸥教授的研究团队提出第一次试图去探索CNN的本质属性,史无前例。汤教授被聘为阿里NASA计划达摩院入选科学家也名至实归。

2015年~至今 AI成为了应用标配

卷积神经网络自从2006年再度走进人们的视线,发展到现在已经快有十个年头。2015年深度学习领域的三巨头LeCun、Bengio 、Hinton在Nature上发表一篇综述,系统的总结了深度学习的发展前世今生,文章写得通俗易懂,全文几乎都没有什么公式,是一篇科普性较强的文章,个人觉得研究深度学习的人员都应该去读一读,题目也很简洁,就叫《Deep Learning》。

对英语有障碍的童鞋可以参考CSDN的中文译文,附链接如下:

深度学习-LeCun、Bengio和Hinton的联合综述(上)

深度学习-LeCun、Bengio和Hinton的联合综述(下)

然后在2016年,CNN再次给人们一个惊喜:谷歌研发的基于深度神经网络和搜索树的智能机器人“阿尔法狗”在围棋上击败了人类,更惊喜的是谷歌在Nature专门发表了一篇文章来解释这个阿尔法狗。

2017年10月19日凌晨,在国际学术期刊《自然》(Nature)上发表的一篇研究论文中,谷歌下属公司Deepmind报告新版程序AlphaGo Zero:从空白状态学起,在无任何人类输入的条件下,它能够迅速自学围棋,并以100:0的战绩击败“前辈”。 (2017.10.20添加)

“Don‘t model the World, Model the Mind.”

“Data is king, algorithm is queen.”

“数据是燃料, 算法是火箭” —— 吴恩达

没有数据, 缺乏高质量的数据, 一切算法都是鸡肋.

引用电影《人工智能》中的一句话,

“世界尽头的地方,是雄狮落泪的地方,是月亮升起的地方,是美梦诞生的地方”,

相信这一次深度学习的复兴将会使我们的生活变得越来越美好。